一离散信源由A,B,C,D四个符号组成,它们出现的概率分别为1/2,1/4,且每个符号的出现都是独立的,消息{AAAAABBACCDDB}熵为2bit/符号。╳81.信息论的创始人是维纳。

第1题:

某信源由A、B、C和D四个符号组成,设每个符号独立等概出现。

参考答案:

第2题:

假设信源是由q个离散符号S1,S2,…,Si…,sq所组成的符号集合,集合中的每个符号是独立的,其中任一个符号Si出现的概率为P(Si),并满足ΣP(Si)=1。那么符号Si含有的信息量I(Si)等于(38),单位是(39)。

A.-logqP(Si)

B.logqP(Si)

C.-log2P(Si)

D.log2P(Si)

第3题:

作为元素系统,若每个元素出现的概率相等,则为无序状态,这时符号熵被称为( )。

A.高熵

B.低熵

C.最小熵

D.最大熵

第4题:

第5题:

假设信源是由q个离散符号S1,S2,…,S1…,Sq所组成的符号集合,集合中的每个符号是独立的,其中任一个符号Si出现的概率为P(Si),并满足∑P(Si)=1。那么符号 Si含有的信息量I(si)等于(31),单位是(32)。

A.-logqP(Si)

B.logqP(Si)

C.-log2P(Si)

D.log2P(Si)

第6题:

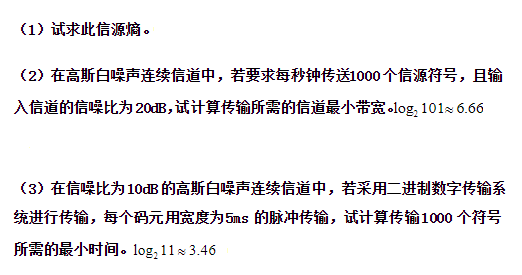

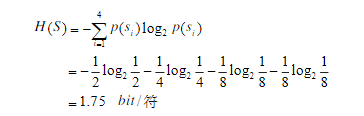

设一离散无记忆信源的输出由四种不同的符号组成,它们出现的概率分别为1/2、1/4、1/8、1/8。

(1)此信源平均每个符号包含的信息熵多大?

(2)若信源每隔10毫秒发出一个符号,那么此信源平均每秒输出的信息量为多少?

参考答案:(1)此信源平均每个符号包含的信息熵为:

(2)若信源每隔10ms发出一个符号,则每秒能否发送100个符号,此信源平均每秒输出的信息量为175bps。

第7题:

假设信源是由q个离散符号S1,S2,…,Si,…Sq所组成的符号集合,集合中的每个符号是独立的,其中任一个符号出现的概率为P(Si),并满足∑P(Si)=1。那么符号Si含有的信息量I(Si)等于( ),单位是( )

A. –logq P(Si)

B. logq P(Si)

C. -log2 P(Si)

D. log2 P(Si)@@@SXB@@@A.比特

B.信息熵

C. dB

D.无单位

第8题:

符号集a、b、c、d,它们相互独立,相应概率为1/2、1/4、1/8/、1/16,其中包含信息量最小的符号是()

A.a

B.b

C.c

D.d

第9题:

作为元素系统,若每个元素出现的概率相等,则为无序状态,这时符号熵被称为( )。

第10题: